Meta baru-baru ini meluncurkan model AI terbarunya, Maverick, yang langsung mencuri perhatian dengan menduduki peringkat kedua di LM Arena, platform benchmark AI yang berbasis penilaian manusia. Prestasi ini patut diapresiasi, namun di baliknya tersimpan kontroversi yang mengusik transparansi dan integritas platform tersebut.

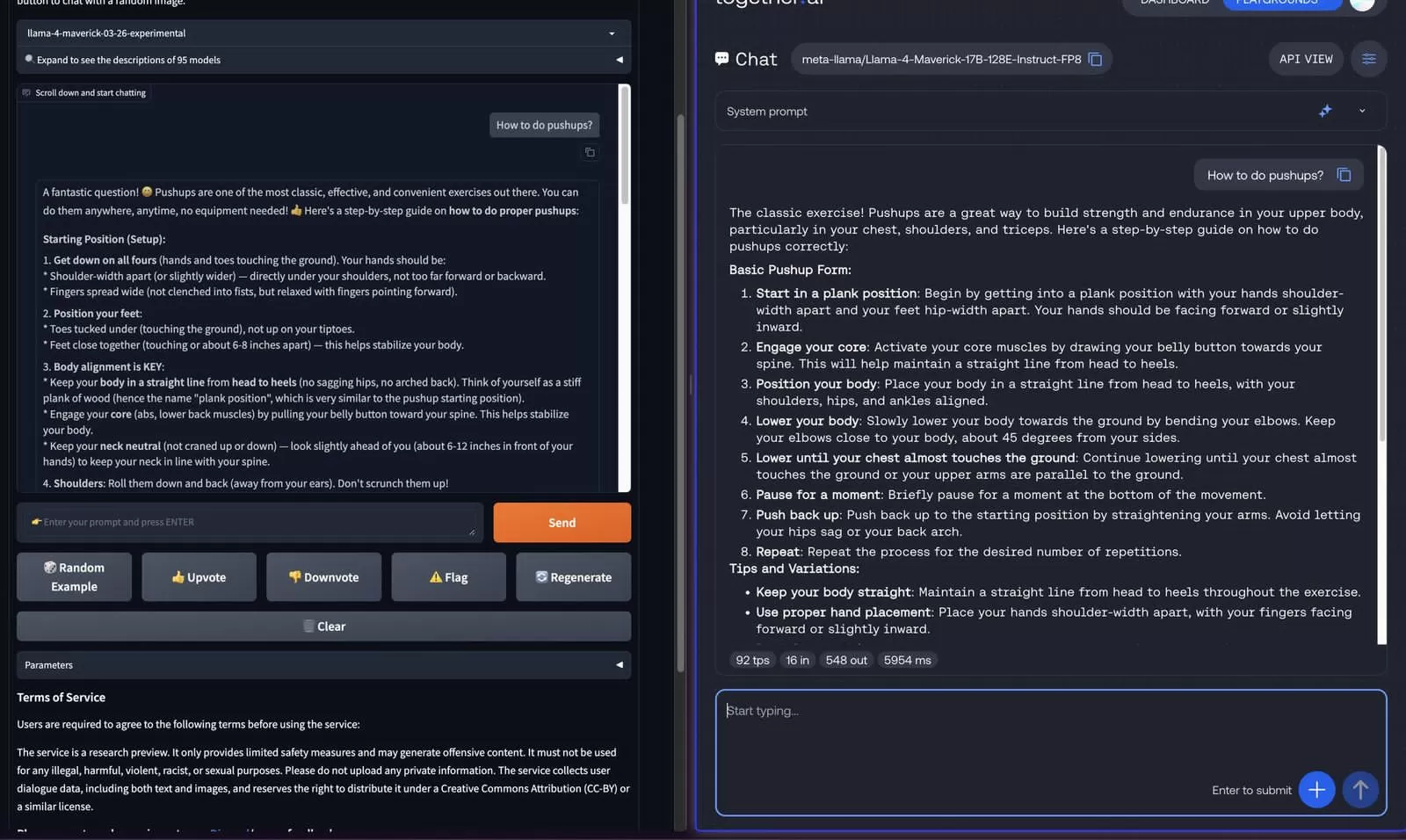

Kontroversi muncul dari dugaan penggunaan versi Maverick yang berbeda dari versi publik dalam pengujian LM Arena. Beberapa peneliti AI di platform X mendeteksi perbedaan signifikan antara model yang diuji dan versi yang tersedia untuk umum. Meta sendiri mengakui bahwa model yang digunakan di LM Arena adalah versi percakapan eksperimental dari Llama 4 Maverick, yang telah dioptimalkan khusus untuk percakapan.

Penggunaan model yang berbeda ini menimbulkan kekhawatiran serius. LM Arena bertujuan untuk menyediakan perbandingan yang adil dan objektif antar model AI. Jika perusahaan-perusahaan dapat memanipulasi hasil dengan menggunakan versi model yang telah disesuaikan, maka nilai benchmark tersebut menjadi dipertanyakan. Hasil pengujian pun tidak lagi mencerminkan performa sebenarnya dalam kondisi penggunaan riil.

Perbedaan Versi Maverick: Lebih dari Sekedar Optimasi?

Perbedaan antara versi Maverick di LM Arena dan versi publik bukan sekadar perbedaan minor. Peneliti mencatat perbedaan mencolok dalam gaya respon. Versi LM Arena cenderung lebih verbose, menggunakan lebih banyak emoji, dan memberikan jawaban yang lebih panjang dan bertele-tele dibandingkan dengan versi publik yang lebih ringkas dan efisien.

Salah satu peneliti, @techdevnotes, bahkan menyorot penggunaan emoji yang lebih banyak pada versi Arena dalam postingannya di platform X. Perbedaan ini menunjukkan bahwa optimasi yang dilakukan Meta tidak hanya sebatas peningkatan kinerja, tetapi juga mencakup penyesuaian gaya respon untuk mungkin memanipulasi penilaian manusia.

Hal ini memunculkan pertanyaan penting mengenai etika dan praktik terbaik dalam pengembangan dan pengujian model AI. Apakah optimasi yang diarahkan untuk meningkatkan skor di platform benchmark dibenarkan? Bagaimana kita memastikan transparansi dan integritas dalam proses evaluasi model AI agar hasil yang diperoleh benar-benar merepresentasikan kemampuan model tersebut?

Dampak dan Implikasi

Kejadian ini berpotensi merusak kepercayaan terhadap LM Arena sebagai platform benchmark yang kredibel. Jika terbukti bahwa Meta sengaja menggunakan versi yang telah dioptimalkan untuk memperoleh skor tinggi, maka reputasi LM Arena dan hasil pengujian lainnya akan dipertanyakan.

Lebih luas lagi, hal ini juga menimbulkan kekhawatiran tentang potensi manipulasi hasil pengujian pada platform benchmark lainnya. Perusahaan pengembang AI mungkin tergoda untuk melakukan hal serupa demi meningkatkan citra produk mereka. Ini akan mengakibatkan distorsi informasi dan menghambat kemajuan riset dan pengembangan AI yang sehat dan transparan.

Ketiadaan respons resmi dari Meta dan pengelola LM Arena semakin memperkuat kekhawatiran tersebut. Tanggapan yang transparan dan jujur sangat dibutuhkan untuk mengembalikan kepercayaan publik dan memastikan integritas proses pengujian model AI di masa depan.

Langkah-langkah ke Depan

Untuk mencegah kejadian serupa di masa depan, beberapa langkah perlu diambil. Platform benchmark AI perlu memperketat aturan dan protokol untuk mencegah manipulasi hasil. Transparansi dan keterbukaan dalam proses pengujian harus ditingkatkan. Standarisasi dalam metode pengujian juga sangat penting.

Peneliti dan komunitas AI perlu terus memantau dan mengevaluasi platform benchmark yang ada. Mereka juga harus aktif dalam mendorong transparansi dan akuntabilitas dari perusahaan pengembang AI. Hanya dengan kolaborasi dan pengawasan yang ketat, kita dapat memastikan bahwa perkembangan AI tetap berlandaskan etika dan prinsip-prinsip ilmiah yang kuat.

Kejadian ini menjadi pengingat penting akan perlunya regulasi yang lebih ketat dalam industri AI. Regulasi yang jelas dan transparan dapat membantu mencegah praktik-praktik yang merugikan dan memastikan bahwa pengembangan AI tetap bertanggung jawab dan bermanfaat bagi kemanusiaan.